Rozumí jazykové modely tomu, co píší, nebo jen papouškují?

Jednou z nejžhavějších debat v oblasti umělé inteligence je otázka, zda velké jazykové modely (LLM) skutečně rozumí textům, které píší, nebo zda jen sofistikovaně papouškují. Tato otázka rozděluje odborníky v oboru a představuje jedno z nejzajímavějších témat současného výzkumu AI.

O čem se vlastně přeme? Jde o to, jestli modely opravdu chápou význam slov, vyvinul se u nich zdravý rozum a mají sociální inteligenci. Nebo je to všechno trik spočívající ve formálních lingvistických operacích. Proč je tato debata důležitá? Nejde jen o akademickou diskusi. Odpověď může mít dalekosáhlé důsledky pro vývoj AI, etiku jejího použití, a dokonce i pro naše chápání lidské inteligence.

Jedna metafora, která se často v této souvislosti používá, je „stochastický papoušek“. To je termín popisující systém, který dokáže generovat text, který se na první pohled může zdát smysluplný a koherentní, ale ve skutečnosti pouze opakuje nebo kombinuje informace, které se naučil při tréninku, bez skutečného porozumění obsahu.

Pohled 1: LLM nemají skutečné porozumění

Tento pohled argumentuje, že navzdory impresivním výstupům LLM nemají skutečné porozumění v lidském slova smyslu. Že nemají vnitřní mentální model světa. Pracují pouze s distribucemi pravděpodobnosti slov a frází, nikoli s koncepty a jejich významy. Zaměřují se čistě na statistické vzory v jazyce, nikoli na hluboké sémantické struktury.

A tím jsou fundamentálně omezeny informacemi obsaženými v jejich trénovacích datech. Nemohou tento limit překročit a vymyslet nic nového, co by šlo nad rámec toho, co bylo obsaženo v jejich tréninku.

Pohled 2: LLM vykazují formu porozumění

Druhý pohled tvrdí, že LLM disponují formou porozumění, i když se může lišit od lidského.

Že LLM dokáží aplikovat naučené koncepty na nové situace a domény, což naznačuje určitou úroveň abstraktního myšlení. Schopnost generovat originální metafory, analogie a tvůrčí texty interpretují jako známku určitého stupně chápání. Dle některých mohou přicházet i s novými úspěšnými vědeckými teoriemi a podobně.

Zdůrazňují emergentní schopnosti LLM. To jsou neočekávané dovednosti, které vznikají při zvětšování modelu a nebyly explicitně součástí tréninku. Mezi ně patří například matematické a analogické uvažování, programování, řešení komplexních úloh, učení z několika příkladů atd. Tyto schopnosti často překvapují i samotné vývojáře.

Někteří zastánci tohoto pohledu argumentují, že i lidský mozek můžeme označit za stochastického papouška, protože se učí napodobováním a často kombinuje existující znalosti novými způsoby.

Který pohled je správný?

To je stále předmětem intenzivní debaty v oblasti filozofie mysli, kognitivní vědy a umělé inteligence. Vědci aktivně zkoumají otázku „porozumění“ u AI pomocí různých metod:

- Winograd Schema Challenge: Tento test, vyvinutý Hectorem Levesquem, zkoumá schopnost modelu porozumět kontextu a řešit víceznačnosti v jazyce. Například: „Radní odmítli demonstrantům povolení, protože se obávali násilí. Kdo se obával násilí?“ Správná odpověď vyžaduje porozumění kontextu.

- GLUE (General Language Understanding Evaluation): Tento soubor úloh, vyvinutý týmem z New York University, testuje různé aspekty jazykového porozumění, včetně analýzy sentimentu, logického vyvozování a parafráze.

- Testy kauzálního uvažování: Tyto testy zkoumají, zda model chápe příčinné souvislosti. Například: „Pokud prší, je mokrá tráva. Je mokrá tráva. Prší?“ Správná odpověď vyžaduje pochopení, že mokrá tráva může mít i jiné příčiny.

- Etická dilemata: Tyto testy hodnotí schopnost modelu navigovat v komplexních etických situacích, což vyžaduje hluboké porozumění lidským hodnotám a společenským normám.

Někteří výzkumníci, jako například Blaise Agüera y Arcas z Google, argumentují, že místo binární klasifikace „rozumí“ versus „nerozumí“ je užitečnější uvažovat o kontinuu porozumění.

Jak fungují jazykové modely

Abychom lépe pochopili tuto debatu, pojďme se podívat na to, jak vlastně LLM fungují. Představte si je jako extrémně složité statistické systémy, které se učí z obrovského množství textových dat. Během trénování model analyzuje vzory a souvislosti v textu a vytváří si vnitřní reprezentaci jazyka a znalostí, tedy snaží se pochopit, jak spolu slova souvisí.

Když pak generuje text, používá tyto naučené vzory k předpovědi pravděpodobného pokračování zadaného vstupu. Je to trochu jako hra na dokončování vět, ale na steroidech.

Důležité je zdůraznit, že modely se neučí slovo od slova, ale vzory a struktury. To je zakořeněno v samotné architektuře neuronových sítí, ze kterých se LLM skládají. Znamená to, že modely jsou předurčeny k tomu, aby generovaly originální obsah, a ne jen reprodukovaly přesné fráze z trénovacích dat.

To ale také znamená, že schopnost modelu generovat originální a tvůrčí texty nemůžeme automaticky brát jako důkaz porozumění. Je to spíš vedlejší produkt toho, jak fungují.

Moje jediný přání je opakování

Když mluvíme o LLM, je těžké si představit to obrovské množství dat, na kterých jsou trénovány. Zkuste to takhle: kdybyste začali číst jednu knihu každý den od doby, kdy žili první neandertálci, až do dneška, přečetli byste zhruba tolik textu, kolik zpracuje velký jazykový model během svého tréninku. Je to prostě neuvěřitelné množství informací.

A tady narážíme na zajímavý problém. S takovým množstvím dat je téměř nemožné s jistotou říct, jestli konkrétní výstup modelu není jen něco, co někde v těch datech viděl. Ve smyslu vzorů.

Ale než začneme LLM obviňovat z pouhého opakování, zamysleme se nad tím, jak „originální“ je vlastně náš svět. Vezměme si třeba hudbu. Skoro celá popmusic si vystačí s variováním 8–12 tónů. Jak k tomu řekl jeden z nejvýznamnějších českých skladatelů Miloš Štědroň: „Pokud se někdo domnívá, že komponuje a tím tvoří nové, tak je na omylu. Je to skutečně latinské componere – dávat dohromady. To dělají dnešní hitmakeři a dělal to i Mozart.“

A co třeba vtipy? Victor Raskin ve své knize „General Theory of Verbal Humor“ identifikoval šest klíčových faktorů, podle kterých je možné analyzovat jakýkoli vtip. Všechny vtipy se ve skutečnosti opírají o velice omezený počet strukturálních a sémantických principů.

Nebo se podívejme na příběhy. Christopher Booker ve své knize „The Seven Basic Plots“ tvrdí, že existuje jen sedm základních typů příběhů. Georges Polti popsal 36 dramatických situací, které podle něj pokrývají všechny možné zápletky knih, filmů a divadelních her.

Co tím vším chci říct? Že pokud LLM dokáže vysvětlit vtip, který nemohl vidět v učících datech, nebo napsat originální příběh, neznamená to nutně, že získal hluboké porozumění. Možná jen velmi šikovně kombinuje existující vzory a struktury – stejně jako to často děláme my, lidé.

Jsou emergentní schopnosti skutečně emergentní?

Teď se dostáváme k jednomu z nejzajímavějších aspektů LLM – takzvaným emergentním schopnostem. To jsou ty neočekávané dovednosti, které se objevují u větších modelů a často překvapují i samotné vývojáře.

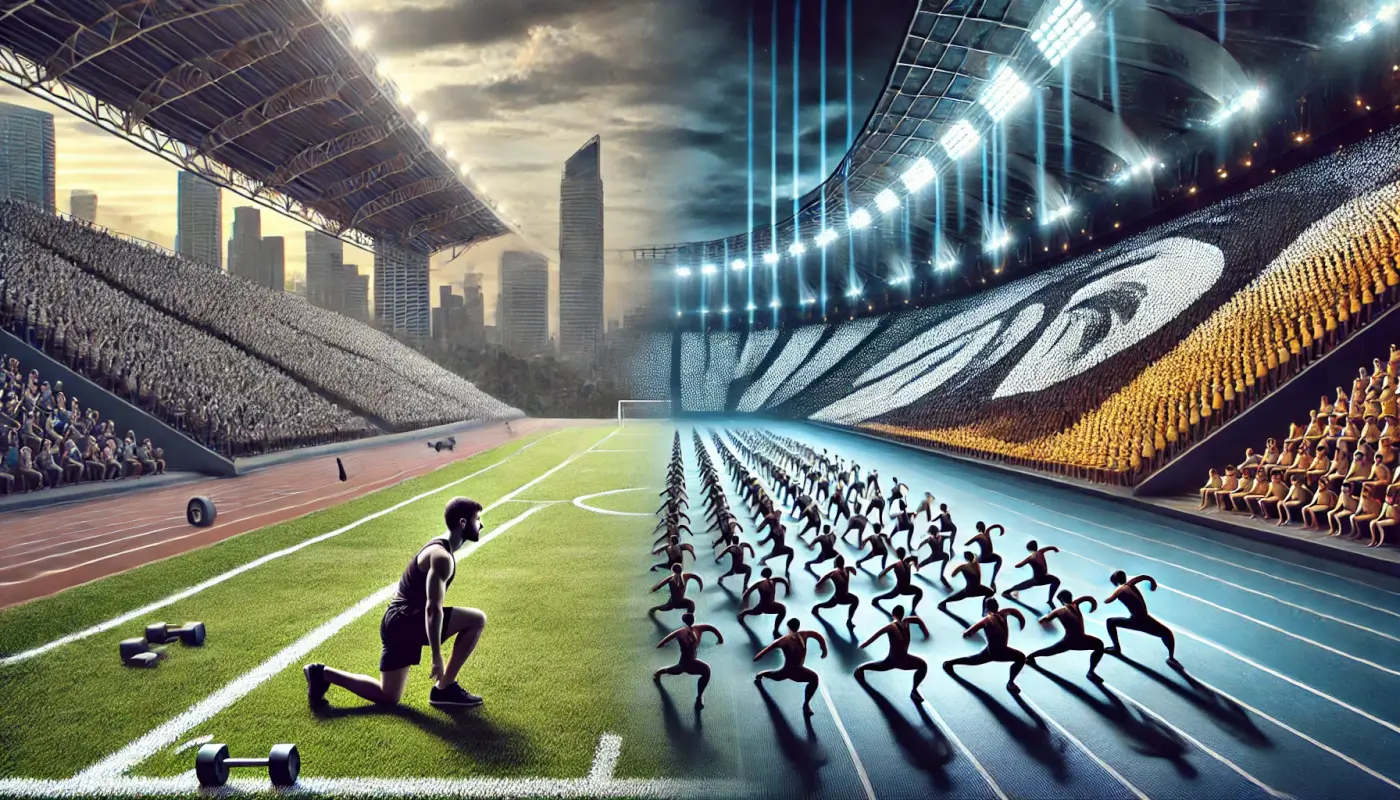

Emergentní jevy jsou fascinující aspekty komplexních systémů, kde nárůst kvantity vede k novým kvalitám. Je to jako když se díváte na spartakiádu – jeden cvičící není nic moc, ale tisíce synchronizovaných cvičenců vytvoří úchvatný vizuální efekt.

Ale pozor, ne vše fascinující je nutně emergentní. Aby byl jev skutečně emergentní, musí být prokazatelně nepřítomný v menších modelech a objevit se až ve větších. Překvapivě a neočekávaně. A v tom jeho nebezpečí a krása. (čtěte hlasem primáře Sovy)

A tady přichází zajímavý zvrat. Nedávná studie Are Emergent Abilities in Large Language Models just In-Context Learning? zkoumala, zda jsou schopnosti LLM běžně označované za emergentní skutečně emergentní. A co zjistili? Že tyto schopnosti jsou spíš výsledkem kombinace lingvistických dovedností a zejména učení v kontextu. Navíc tyto závěry byly konzistentní napříč různými rodinami modelů a velikostmi.

Co to znamená? Že vývoj schopností LLM může být předvídatelnější, než jsme si mysleli. To má obrovský význam pro diskusi o bezpečnosti umělé inteligence. Zpochybňuje to obavy z potenciálně nebezpečných latentních schopností LLM, které se mohou náhle vynořit. Naznačuje, že můžeme lépe předvídat a řídit vývoj těchto systémů.

Neznamená to, že vývoj AI je bez rizik. Ale možná nejsme tak blízko scénářům z vědeckofantastických filmů, kde se AI náhle stane superinteligentní a ovládne svět.

Tak co si z toho všeho odnést?

Otázka, zda LLM skutečně rozumí tomu, co říkají, zůstává otevřená. Nasadili jsme jim lidskou masku a této iluzi snadno podléháme. Věříme v jejich porozumění mnohem víc než u jiných generativních technologií. Když nám jazykový model odpoví na složitou otázku, jsme v pokušení mu přisoudit hluboké chápání. Ale věříte stejně, že generátor písniček má cit pro hudbu, pro emocionální náboj melodie, nebo chápe, jak harmonie působí na lidskou duši? Hádám, že spíš ne.

Z mé každodenní praxe musím říct, že modelům hluboké porozumění spíš chybí. Narazil jsem na nespočet případů, kdy model selhal při chápání i těch nejbanálnějších konceptů, pokud nebyly v jeho učících datech (třeba oboustrannost vztahu syna a matky). To jsou zjevná omezení okovy tréninku, a selhávají, když se mají posunout za tyto meze.

Ale víte co? Pro praktické využití není až tak podstatné, jestli modely opravdu rozumí tomu, co píší. LLM jsou tak jako tak tím nejužitečnějším nástrojem, který lidstvo samo sobě dosud nadělilo. Otevírají novou kapitolu přístupu k informacím. Na rozdíl od klasických vyhledávačů, které hledají podle shody slov, LLM chápou kontext a záměr dotazu. S lehkostí propojují zdánlivě nesouvisející informace a generují relevantní odpovědi i na nové otázky. Ale hlavě syntetizují znalosti. Tím otevírají dveře úplně novým možnostem ve všech oblastech lidského snažení.

Také si myslím, že je ještě brzy na to, abychom LLM přímo srovnávali s lidským mozkem. Spousta vědců a filozofů vidí mezi nimi zásadní rozdíly. Ale už jen to, že vedeme tuhle debatu, nás nutí přehodnotit, co vlastně znamená inteligence a vědomí. A možná právě tohle přehodnocení bude jedním z velkých přínosů vývoje umělé inteligence pro lidské poznání.